Lubię być mobilny

Opublikowano:

19 grudnia 2019

Od:

Do:

Początek:

Koniec:

Kolejnym rozmówcą w cyklu poświęconym kompozycji elektroakustycznej na Akademii Muzycznej jest Michał Janocha, jeden z pierwszych absolwentów kierunku, a obecnie wykładowca. Rozmawiamy między innymi o tym, jak w swojej twórczości łączy rozmaite środki i czy można komponować na smartfonie.

PIOTR TKACZ: Zanim zacząłeś studiować kompozycję elektroakustyczną, ukończyłeś studia kompozytorskie u Lidii Zielińskiej. Dlaczego zdecydowałeś się na ten kierunek? Patrząc z perspektywy czasu, co dały ci te studia, czy spełniły oczekiwania, a może czymś zaskoczyły?

MICHAŁ JANOCHA: Było trochę inaczej. Studia na wszystkich trzech kierunkach w Akademii odbyłem właściwie równolegle. Najpierw kompozycja, rok później dyrygentura symfoniczna, po dwóch latach kompozycja elektroakustyczna – więc był taki czas, kiedy studiowałem wszystkie kierunki w tym samym momencie. W międzyczasie było jeszcze półroczne stypendium w Budapeszcie i studiowanie kompozycji elektroakustycznej w LFZE EZM u Andrei Szigetvári, a przed studiami muzycznymi architektura i urbanistyka na Politechnice Łódzkiej.

Dlaczego kompozycja elektroakustyczna? To był głód wiedzy. Jeszcze zanim się zdecydowałem, podczas studiów u Lidii Zielińskiej rozpocząłem próby z tego rodzaju muzyką. Drugi kierunek dał mi przede wszystkim więcej czasu, niż mógłbym poświęcić, studiując tradycyjną kompozycję.

Interesowało mnie i jedno, i drugie, a zwłaszcza łączenie obydwu tych światów. Dodatkowy kierunek okazał się strzałem w dziesiątkę, wielu ważnych dla mnie przedmiotów w programie tradycyjnej kompozycji po prostu nie było. Poza tym – świetna atmosfera, mnóstwo kreatywności i możliwości.

Opowiedz więcej o łączeniu tych dwóch światów – instrumentów i elektroniki. Czy możesz wyjaśnić, jak stosujesz live electronics?

Zaczęło się od szukania nowych brzmień w muzyce instrumentalnej, kiedy to pole się wyczerpało (albo po prostu kiedy rezultaty przestały być zadowalające), dotarło do mnie, że wiele z tych rzeczy jest osiągalnych za pomocą elektroniki – i to w dużo prostszy sposób.

Ten „dużo prostszy sposób” to jednak pułapka. Łatwo zachłysnąć się możliwościami, jakie daje muzyka elektroakustyczna. Wystarczy przecież włączyć w programie jedną, dwie wtyczki, zagrać z nimi na dowolnym instrumencie i otrzymujemy efekt nieosiągalny w muzyce akustycznej.

I tu zaczyna się kwestia świadomości – postawienia sobie pytania: czy o to właśnie mi chodziło? Myślę, że dlatego też warto studiować kompozycję elektroakustyczną. Mamy przecież u nas niejednego studenta bardzo biegłego w używaniu technologii, z wieloma koncertami na swoim koncie – tacy też po coś tu przychodzą.

Z wiedzą pojawia się świadomość, a świadome używanie środków podnosi jakość utworów kilka oczek wyżej. Poza tym taką świadomość po prostu słychać potem w utworze – albo nie.

Wracając do łączenia instrumentów i elektroniki: mnie chyba najbardziej interesuje zacieranie granicy między światem akustyki i elektroakustyki.

A jak to działa w praktyce?

Pamiętam taki utwór – „Should I touch you trough the glass?” na klarnetobój i ukrytą elektronikę. Pomysł był prosty: wykonawcy w kieszeni spodni czy marynarek mieli ukryte małe głośniki. Na początku z głośników wydobywały się dźwięki grane przez duet, ale z harmonicznym rozszerzeniem, albo okazywało się, że obój gra jednocześnie trzy multifony [dźwięki kombinowane – przyp. red.].

Wprawne ucho dało się nabrać tylko do pewnego momentu, ale niewprawne mogło nie zorientować się aż do końca, co tu zostało pokazane. Na tym akurat utwór tracił. Co ciekawe, obój i klarnet były połączone (zdjęte czary, jeden instrument przedłużony drugim), co sprawiało, że możliwe było granie dwóch tonów czy multifonów na jednym instrumencie. Trudno było powiedzieć, co jest prawdą, a co nie. I tak samo to napisać! Tu bardzo cenna była pomoc oboistki, Natalii Kok, z którą współpracuję już wiele lat. Z utworu nie byłem szczególnie zadowolony, ale eksperyment się powiódł.

Wiedziałem, co z tym zrobić dalej. W moim koncercie fortepianowym „The blue oranges” na rozszerzony fortepian i orkiestrę, live electronics służy poszerzeniu możliwości instrumentu solowego. W środku fortepianu umieszczone są dwa głośniki wibracyjne. Przetworzony dźwięk fortepianu trafia do nich i rezonuje w płycie instrumentu – wszystko stapia się wewnątrz instrumentu.

Posłużyło mi to do modyfikowania spektrum i rezonansu fortepianu, a także do przetworzenia granych przez solistę dźwięków. Często live electronics służy mi jako rodzaj reakcji, ale głównie przetworzeń instrumentu solowego („Hippocambreak!” na wiolonczelę i live electronics, „Hùndùn” na perkusję i surround live electronics, „Nu” na saksofon i live electronics), lub jako rodzaj instrumentu, np. w utworze „Five Roots” na telefony komórkowe i live electronics.

Aktualnie pracuję nad utworem na dyrygenta i live electronics. Żywa elektronika to potężne narzędzie i właśnie tę wszechstronność staram się pokazywać naszym studentom podczas zajęć z live electronics.

Używasz programów komputerowych czy również jakiś sprzętów, urządzeń?

Lubię być mobilny. Z tego powodu stawiam najczęściej na użycie komputera i budowanie własnych muzycznych urządzeń w Max/MSP. Poza tym mam oczywiście sensory czy kontrolery.

Bardzo lubię wykorzystywać smartfony – prawie każdy ma jeden w kieszeni, a poza tym są od razu wyposażone w wiele użytecznych czujników – odległości, naświetlenia – żyroskop, GPS itd. Za pomocą tych czujników można zagrać utwór, wystarczy to odpowiednio zaprogramować.

A interesują cię smartfonowe aplikacje do robienia muzyki? Myślisz, że takie proste, często wręcz intuicyjne programy mogą być dla kogoś zachętą do zajęcia się tworzeniem na poważnie? Czy może ta łatwość to też pułapka?

Wolę budować swoje narzędzia. Gotowe aplikacje służą mi najczęściej tylko do obsługi sensorów, którymi posługuje się telefon, potem informacje te wysyłam do swoich narzędzi i dopiero tam tworzę dźwięk. Jednak myślę, że aplikacje, którymi „można grać”, to cudowna sprawa. Im więcej ludzi interesuje się muzyką, tym lepiej!

Domowe muzykowanie to chyba istotna część życia społecznego – kiedyś przy harfie, fortepianie, cytrze, gitarze, a dzisiaj… czemu nie przy smartfonie? Zwłaszcza praktyka wśród amatorów jest istotna, a nauka gry na instrumencie nie jest niestety dostępna dla każdego.

Zredukowanie kontaktu z muzyką tylko do słuchania pozbawia ogromu wspaniałych przeżyć i szeroko pojętego rozwoju: intelektualnego, emocjonalno-społecznego…

Oczywiście dźwięk, jaki wydaje z siebie smartfon swoimi małymi głośnikami, jest bardzo niskiej jakości. Nie zastąpi to doświadczeń kontaktu z żywym akustycznym instrumentem. Myślę też, że kiedy ktoś chce zająć się profesjonalnym tworzeniem muzyki, takie gotowe aplikacje zwyczajnie przestają wystarczać. No i cały czas pozostaje kwestia świadomego wyboru i użycia środków, a nie korzystania z tego, co akurat dostępne w gotowej aplikacji. Jednak jeśli jest tam dokładnie to, czego nam trzeba, i jest gotowe do użycia – czemu nie?

Dla mnie nie ma różnicy, czy muzyka powstała za pomocą komputera, harfy, smartfona, deski, miary budowlanej czy przecinaka do jajek. Ważne, że efekt jest dobry. Każdy z tych instrumentów ma swoją specyfikę i nie stworzy dźwięków takich jak pozostałe. Zresztą pomysłowość zawsze wychodzi na plus.

Poszukując nowych efektów nie tylko do instrumentów akustycznych, dodałeś elektronikę, ale zacząłeś też sięgać po inne środki. Opowiedz o swoich przedsięwzięciach multimedialnych i performatywnych oraz o tym, skąd w ogóle taka potrzeba budowania bardziej złożonych sytuacji, całościowych środowisk?

Myślę, że trzonem komponowania jest pytanie o wpływ na słuchacza. Tworzymy – wywołujemy emocje, odczucia, nastroje, pobudzamy percepcję, sprawiamy wrażenia, bawimy się iluzją, manipulujemy upływem czasu.

Środki pozamuzyczne służą temu samemu. Potęgują idee albo uzupełniają je o to, czego sam dźwięk nie byłby w stanie osiągnąć. Im więcej zmysłów zostanie zaangażowanych, tym większa imersja naszej kompozycji.

Performatywnych utworów skomponowałem stosunkowo mało, ale zdarzały się: „O świetle” na kwartet smyczkowy – rodzaj teatru instrumentalnego, bez żadnego dźwięku wydobytego z instrumentów; „78” na wiolonczelę solo… To było jeszcze na początku moich studiów, później nie było to dla mnie już tak atrakcyjne.

Wszelkie środki pozamuzyczne lubię mieć precyzyjnie zakomponowane, tak żeby z pozostałymi elementami tworzyły spójną całość. Albo decyduję się na instalację i wtedy na przykład angażuję widza w sposób zupełnie swobodny.

Zwiększona swoboda wykonawcza czy elementy improwizacji to środki, z których czasem zdarza mi się korzystać, ale zawsze dokładnie określam wtedy, gdzie i dlaczego coś takiego w utworze się pojawiło.

Za to multi- czy też intermedialnych utworów mam na koncie już trochę więcej, w tym instalacje „The Mark”, „You are the sound”, „Easy Baby I’m fine”, sporo kompozycji łączących instrumenty akustyczne i elektronikę lub wideo – „Maybe I’m drunk” na dotar, live electronics i wideo. I choćby najnowszy „Słyszę, że patrzysz”, czyli spektakl multimedialny na śpiewaka aktora, zespół, surround live electronics i wideo, którego premiera odbyła się w 2019 roku podczas Music.Design.Form Festival w Szczecinie.

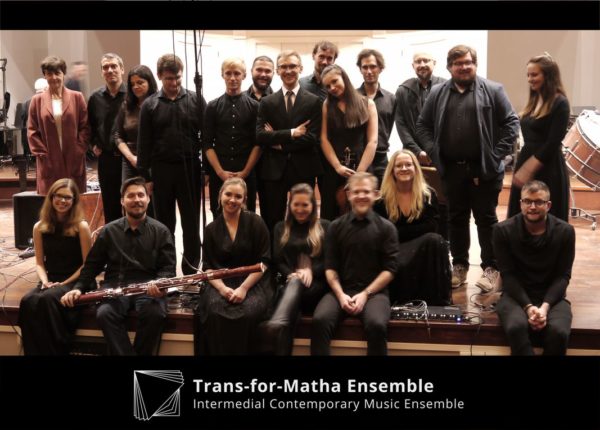

MICHAŁ JANOCHA (ur. 1990 w Łowiczu) – kompozytor i dyrygent, obecnie wykładowca, a wcześniej potrójny absolwent Akademii Muzycznej w Poznaniu: kompozycja (klasa prof. Lidii Zielińskiej), dyrygentura symfoniczna (klasa prof. Marcina Sompolińskiego) oraz kompozycja elektroakustyczna. W latach 2009–2013 student Politechniki Łódzkiej na kierunku architektura i urbanistyka. Jego utwory wykonywano na wielu festiwalach, jak choćby Warszawska Jesień i Poznańska Wiosna Muzyczna, współpracował również między innymi z Filharmonią Poznańską.